作者:黄震华,杨顺志,林威,倪娟,孙圣力,陈运文,汤庸

作者单位:华南师范大学计算机学院;同济大学电子与信息工程学院;华南师范大学哲学与社会发展学院;北京大学软件与微电子学院;达而观智能(深圳)有限公司研发部

高性能的深度学习网络通常是计算型和参数密集型的,难以应用于资源受限的边缘设备。

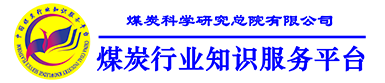

为了能够在低资源设备上运行深度学习模型,需要研发高效的小规模网络.知识蒸馏是获取高效小规模网络的一种新兴方法,其主要思想是将学习能力强的复杂教师模型中的“知识”迁移到简单的学生模型中。

同时,它通过神经网络的互学习、自学习等优化策略和无标签、跨模态等数据资源对模型的性能增强也具有显著的效果。

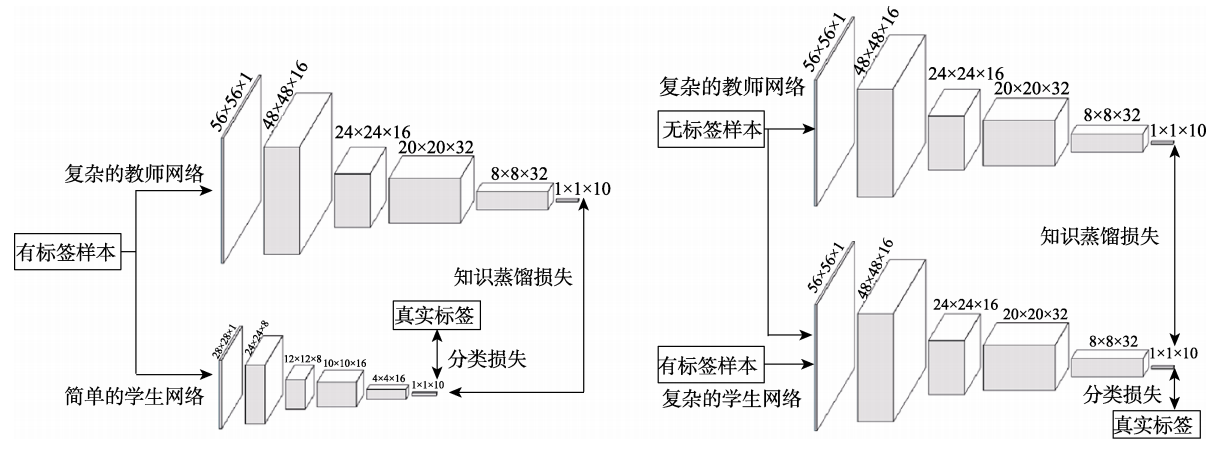

基于在模型压缩和模型增强上的优越特性,知识蒸馏已成为深度学习领域的一个研究热点和重点.本文从基础知识,理论方法和应用等方面对近些年知识蒸馏的研究展开全面的调查,具体包含以下内容:

(1)回顾了知识蒸馏的背景知识,包括它的由来和核心思想;

(2)解释知识蒸馏的作用机制;

(3)归纳知识蒸馏中知识的不同形式,分为输出特征知识、中间特征知识、关系特征知识和结构特征知识;

(4)详细分析和对比了知识蒸馏的各种关键方法,包括知识合并、多教师学习、教师助理、跨模态蒸馏、相互蒸馏、终身蒸馏以及自蒸馏;

(5)介绍知识蒸馏与其它技术融合的相关方法,包括生成对抗网络、神经架构搜索、强化学习、图卷积、其它压缩技术、自动编码器、集成学习以及联邦学习;

(6)对知识蒸馏在多个不同领域下的应用场景进行了详细的阐述;

(7)讨论了知识蒸馏存在的挑战和未来的研究方向。

知识蒸馏的两个技术方向:模型压缩(左)和模型增强(右)

《知识蒸馏研究综述》组织结构图

论文链接